LM Studioを使って、LLM(大規模言語モデル)をローカル環境で利用する方法を紹介します。

Gemma 3、DeepSeek R1、Phi 4など、色々なLLMを手軽に利用できるので、興味があれば試してみてください。

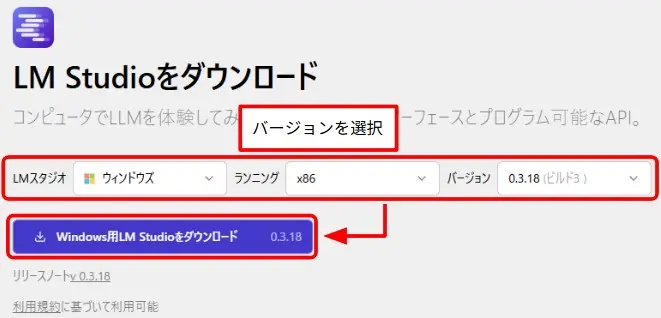

- LM Studioのダウンロードサイトでバージョンを選択し、ダウンロードボタンをクリック

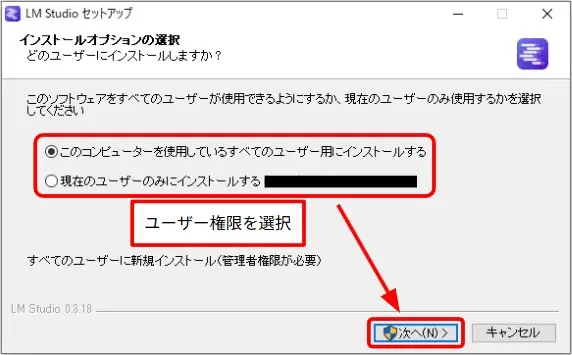

- ダウンロードしたファイルを実行し、LM Studioを使用するユーザー権限を選択して「次へ」をクリック

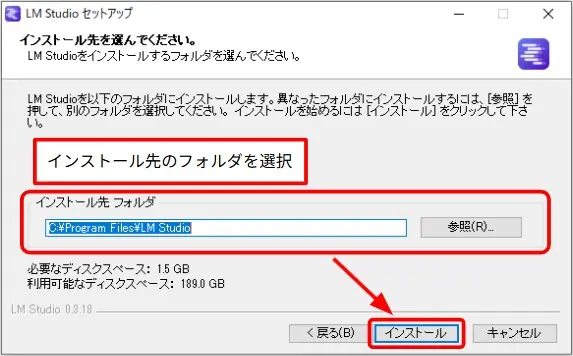

- インストール先のフォルダを選択して「インストール」をクリック

- インストールが終了したら「完了」をクリック

- LM Studioを起動して「Let’s get started」をクリック

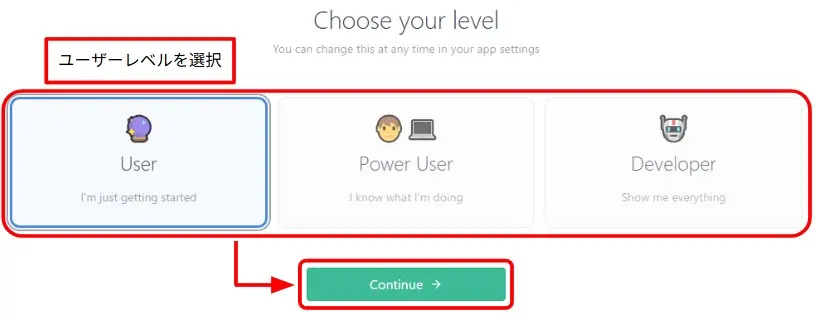

- ユーザーレベルを選択して「Continue」をクリック

(ユーザーレベルによって提供される機能とインターフェースが異なります。レベルはいつでも自由に切り替えられるので、最初は「User」で問題ありません。)

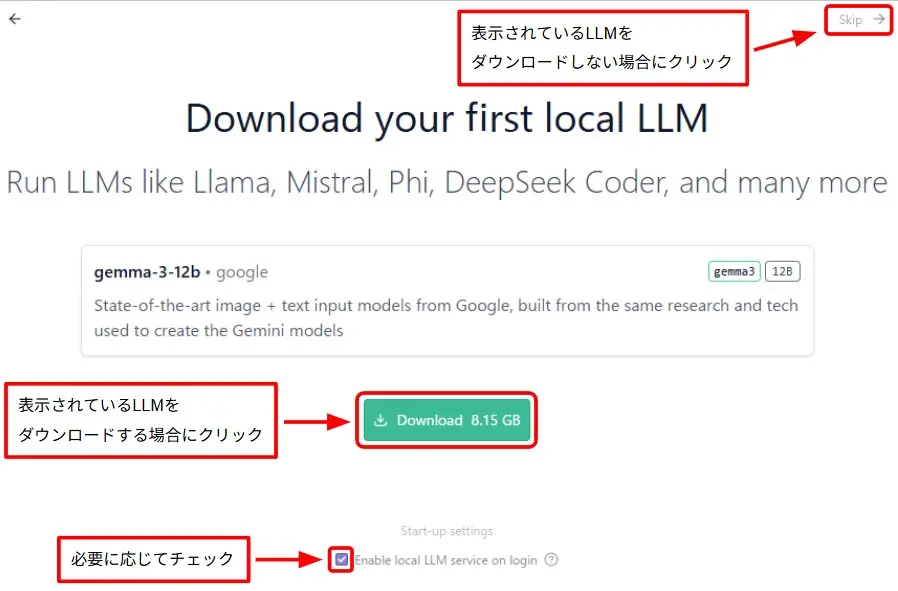

- LM Studioを立ち上げずにLM StudioのLLMを利用したい場合は「Enable local LLM service on login」にチェックを入れる

- LLMモデルをダウンロードする場合は「ダウンロード」、しない場合は「Skip」をクリック

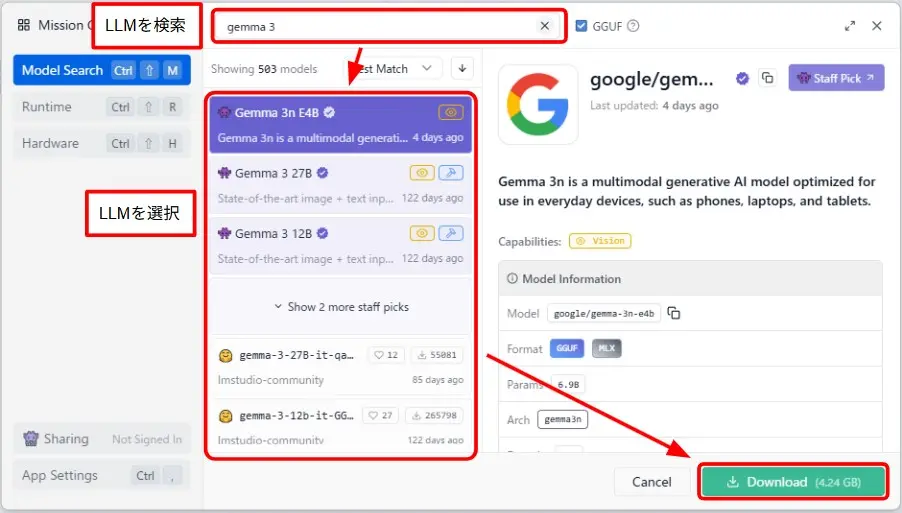

LLMのダウンロード

LM studio内から、Hugging FaceにあるLLMをダウンロードできます。

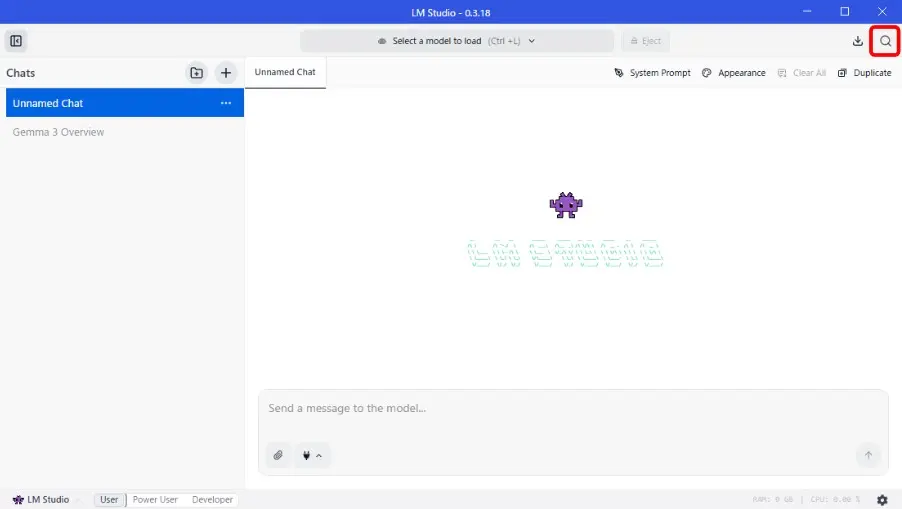

- LM Studioを起動し、ウィンドウ右上の「Discover」アイコンをクリック

(ユーザーレベルが「Power User」か「Developer」なら、アイコン位置はウィンドウ左)

- 開いたウィンドウでLLMを検索して選択し、「Download」をクリック

ダウンロードが完了すれば、LLMを使えます。

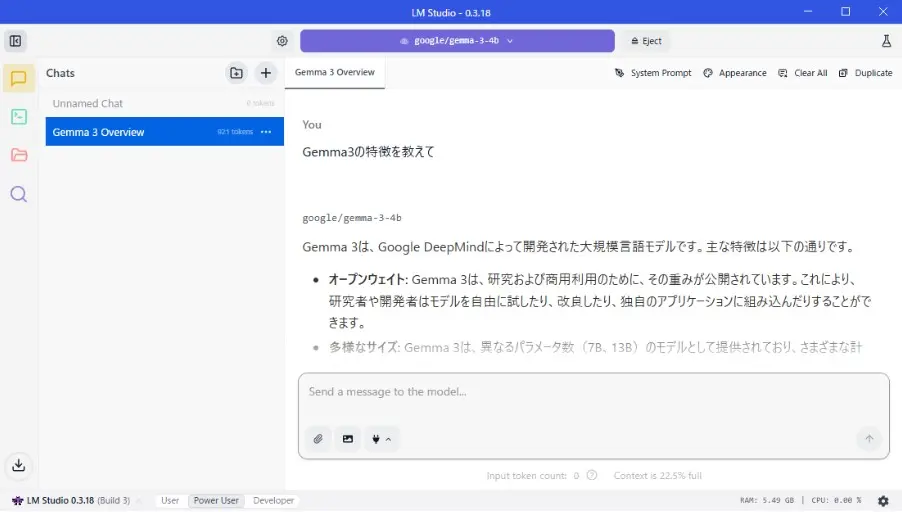

使用例

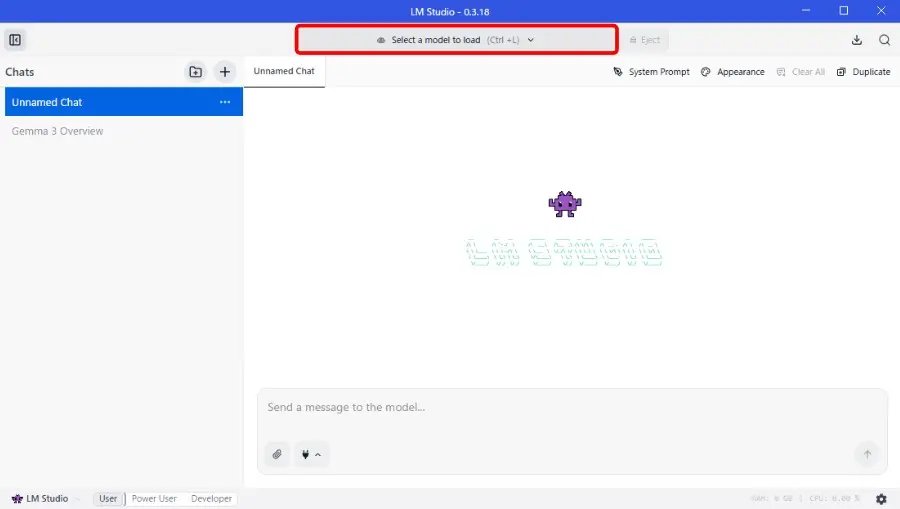

LLMの実行

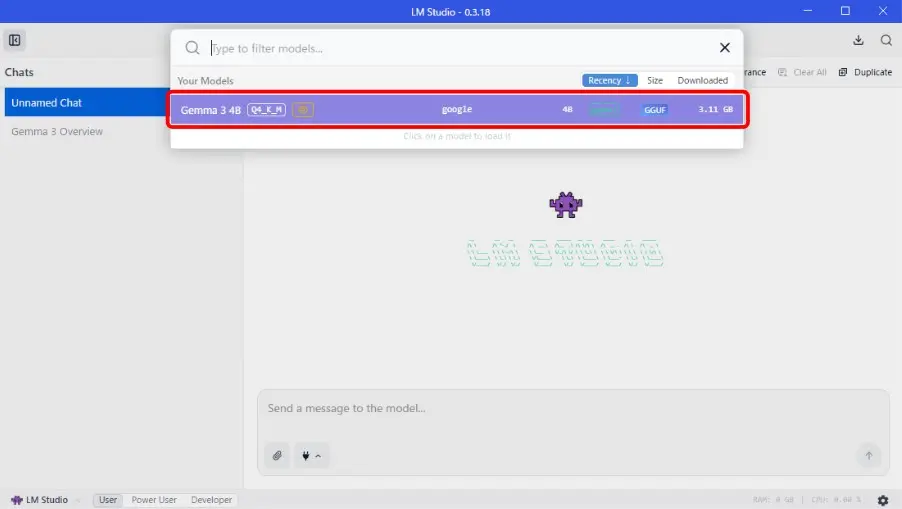

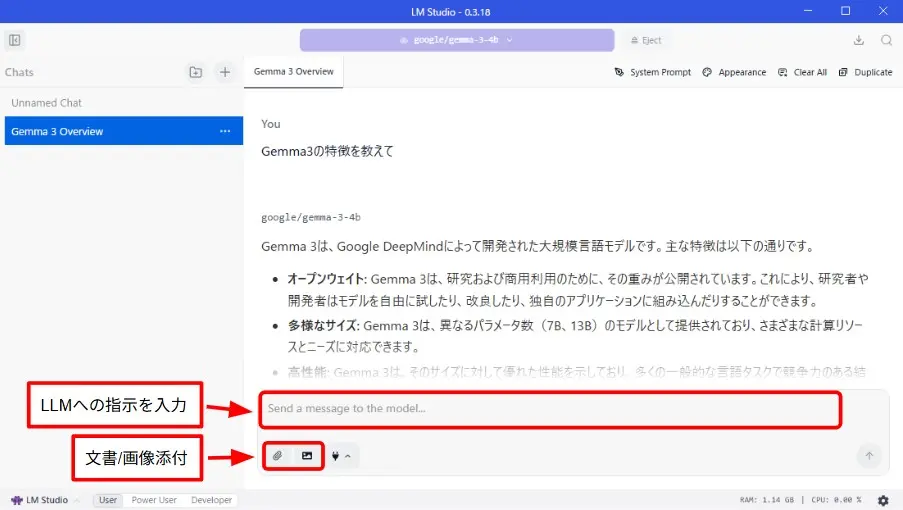

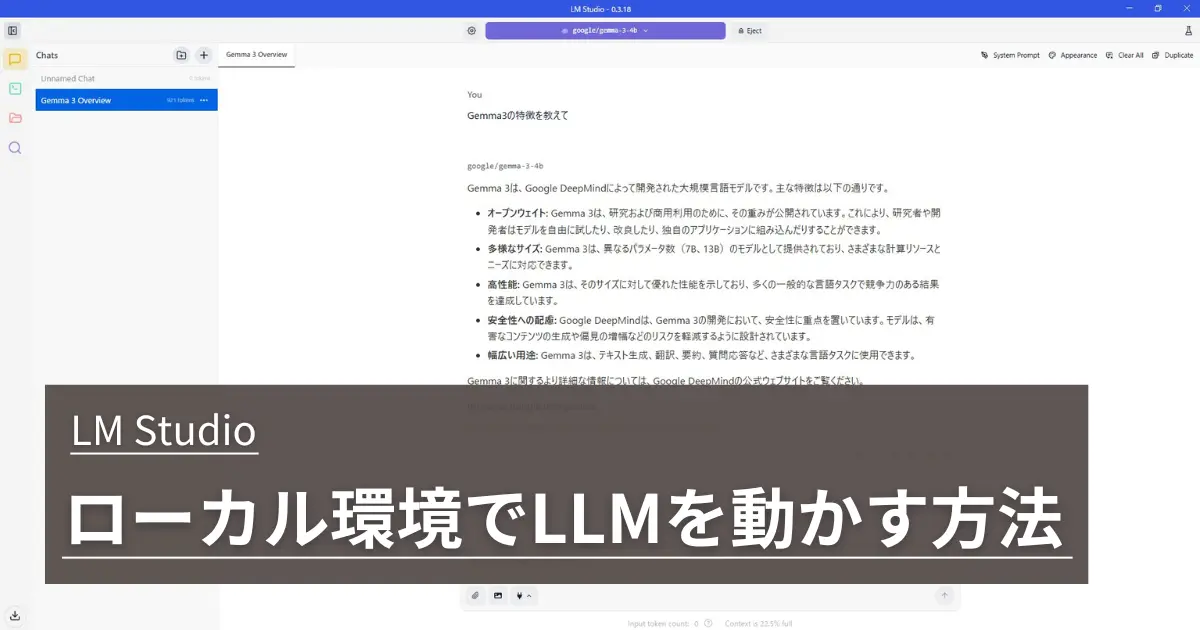

LLMを起動した後、チャットで指示を出せばLLMが応答します。

- ウィンドウ中央上の「Select a model to load」をクリック

- 開いたウィンドウで起動するLLMをクリック

- LLMが起動したら、ウィンドウ下部の入力欄にLLMへの指示を入力

(LLMが対応していればクリップのアイコンから文書ファイル、写真のアイコンから画像ファイルを添付してLLMに参照させることができます。)

APIサーバー機能

LM studioにはAPIサーバーの機能があり、APIを介して他のソフトウェアでLLMを利用することができます。

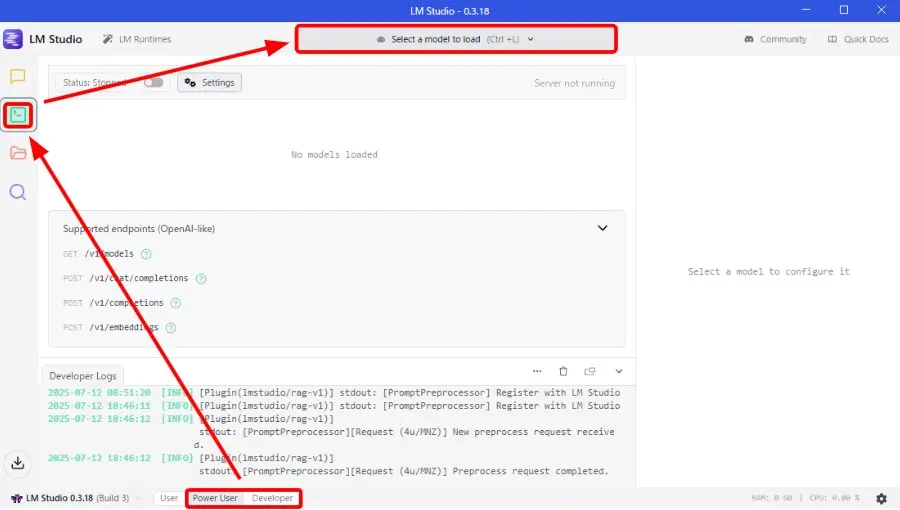

- ウィンドウ右下の「Power User」または「Developer」をクリックしてユーザーレベルを変更

(ユーザーレベルによりUIが変わります。) - ウィンドウ左上の「Developer」アイコンをクリック

- ウィンドウ中央上の「Select a model to load」をクリック

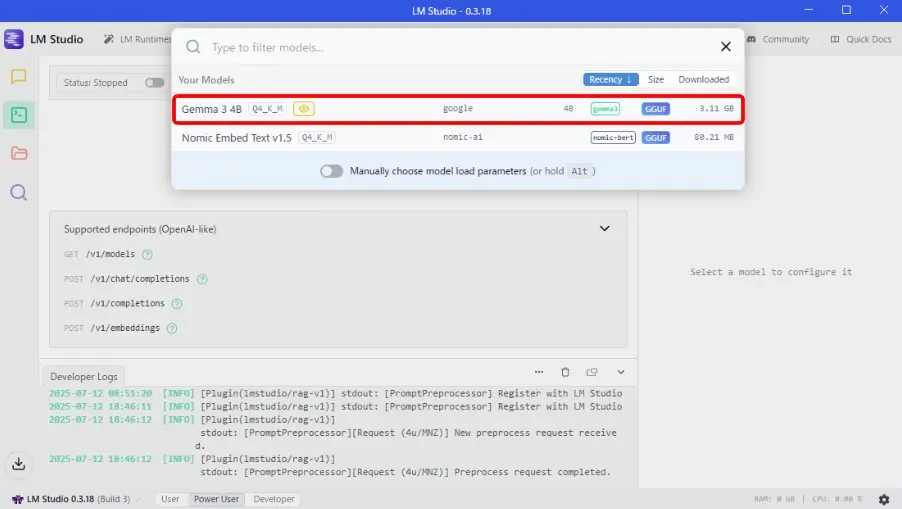

- 開いたウィンドウで起動するLLMをクリック

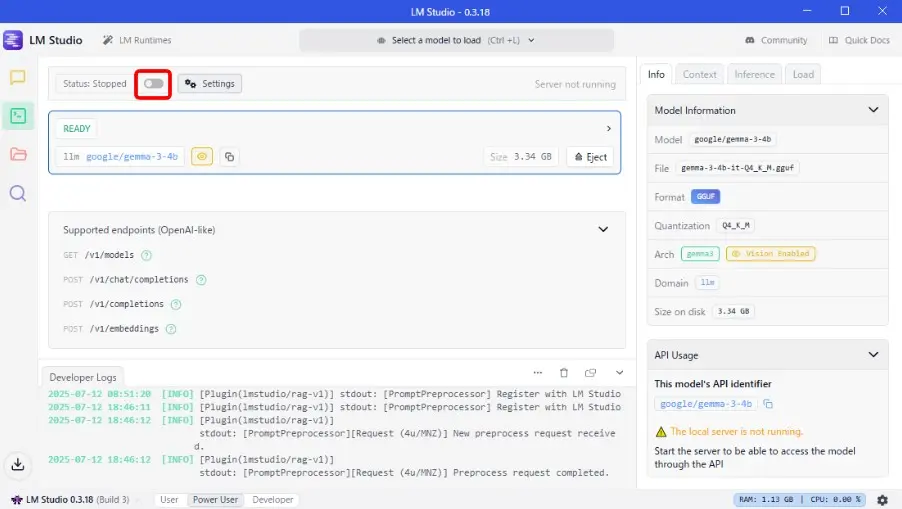

- LLMが起動したら、「Status Stopped」右のスイッチをクリック

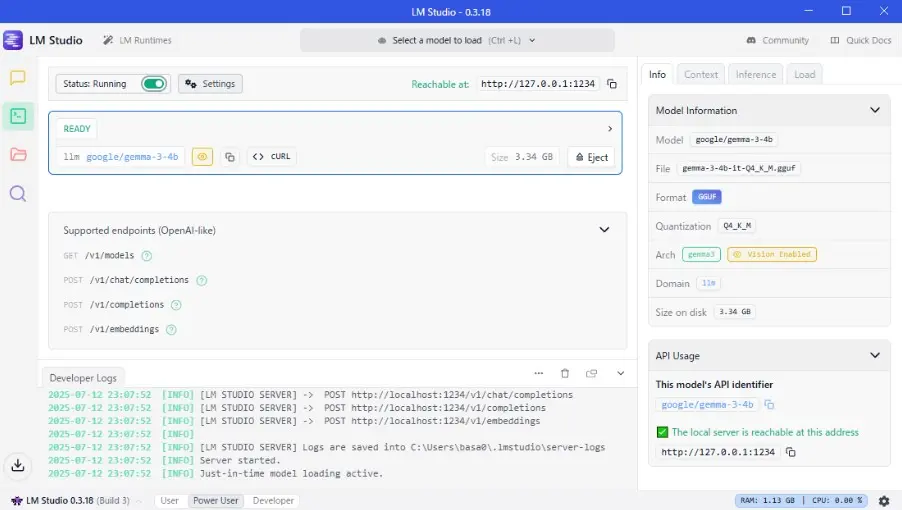

これでAPIサーバーが起動し、他のソフトウェアからAPIを利用してLLMを動かせます。

以上でローカル環境でLLMを動かせるようになりました。

APIサーバーの機能を利用して、ComfyUIやUE5と連携できると面白そうです。

コメント